摘要:,,本文探讨了Apache Hudi在数据湖中的实时写入性能。Hudi作为Hadoop上的表格式,为大数据处理提供了高效的数据写入和读取方案,尤其在实时写入场景下表现突出。其高吞吐量、低延迟、数据一致性和增量更新的特点得益于独特的设计和工作原理。通过参数优化、数据分区、数据压缩等优化策略,以及选择合适的存储格式、合理设计数据结构、利用异步写入等最佳实践,可以进一步提高Hudi的实时写入性能。Hudi在未来数据湖建设中将发挥重要作用。

随着大数据技术的不断发展,数据湖作为大数据存储和处理的核心组成部分,其性能优化变得越来越重要,Apache Hudi(Hadoop Upserts Deletes and Incrementals)是数据湖的一种高效存储解决方案,特别在实时写入场景下表现出卓越的性能,本文将深入探讨Hudi的实时写入性能,包括其工作原理、性能特点、优化策略以及最佳实践。

在大数据处理过程中,数据写入是一个核心环节,传统的数据写入方法在处理大规模数据集时面临诸多挑战,如数据延迟、性能瓶颈等,Hudi作为一种新型的存储系统,旨在解决这些问题,提供高效的数据写入和读取性能,特别是在实时写入场景下,Hudi的表现尤为突出。

Hudi实时写入性能解析

1、Hudi概述

Apache Hudi是Hadoop上的表格式,用于处理大型数据集,尤其是需要高效数据写入和读取的场景,它支持数据集的增删改操作,并提供了高效的增量数据读取功能,Hudi的设计使其在处理大规模实时数据流时表现出卓越的性能。

2、实时写入性能特点

(1)高吞吐量:Hudi采用了一种高效的写入模型,支持高并发写入,能够在短时间内处理大量数据。

(2)低延迟:通过优化数据存储和索引结构,Hudi实现了低延迟的数据写入,在实时场景中,数据可以几乎实时地写入Hudi表。

(3)数据一致性:Hudi保证了数据的一致性,即使在并发写入的场景下,也能确保数据的准确性和完整性。

(4)增量更新:Hudi支持增量更新操作,只更新发生变化的数据,提高了写入效率。

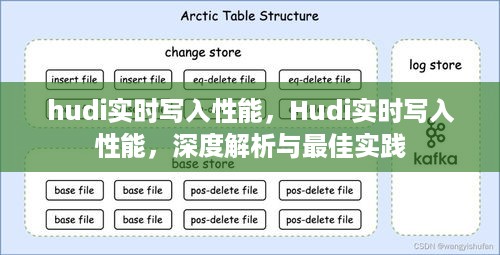

3、工作原理

Hudi的实时写入性能得益于其独特的设计和工作原理,它采用了COW(Copy-On-Write)策略,在数据修改时只记录修改操作,而不是实际修改数据,这使得Hudi在处理大量并发写入时,能够保持高性能和低延迟,Hudi还采用了索引和分区技术,提高了数据查询和写入的效率。

优化策略

尽管Hudi已经提供了优秀的实时写入性能,但在实际应用中,我们还可以通过一些优化策略进一步提高性能。

1、参数优化:调整Hudi的配置参数,如并发度、内存大小等,以适应不同的工作负载和硬件环境。

2、数据分区:合理设计数据分区策略,以提高数据写入的并发性和效率。

3、数据压缩:使用数据压缩技术减少数据存储大小,降低网络传输和磁盘I/O的开销。

4、使用缓存:利用缓存技术减少磁盘访问次数,提高数据写入的性能。

最佳实践

1、选择合适的存储格式:根据实际需求选择合适的Hudi表格式,如DeltaStreamer或HoodieTable等。

2、合理设计数据结构:在设计数据结构时,考虑到查询和写入的平衡,避免过度设计导致性能下降。

3、利用异步写入:使用异步写入提高写入性能,减少写操作对主线程的影响。

4、定期优化表结构:随着业务需求的变化,定期评估和调整表结构,以保持高性能。

5、监控和诊断:使用监控工具实时监控Hudi的性能指标,及时发现并解决性能问题。

Apache Hudi提供了一种高效的实时写入解决方案,通过其独特的设计和工作原理,实现了高吞吐量、低延迟的数据写入,通过优化策略和最佳实践,我们可以进一步提高Hudi的实时写入性能,随着大数据技术的不断发展,Hudi将在未来的数据湖建设中发挥越来越重要的作用。

转载请注明来自山东高考日语培训,日本留学,枣庄日语培训机构,本文标题:《Hudi实时写入性能深度解析与最佳实践指南》

蜀ICP备2022005971号-1

蜀ICP备2022005971号-1

还没有评论,来说两句吧...